Odnośnie ciekawych rozwiązań w zakresie nośników, polecam zapoznać się z opisanym już na ifarze projektem Rosetta.

Jak wiadomo kamień z Rosetty przetrwał przez przypadek, ale stał się inspiracją dla inżynierów i naukowców. Którzy postanowili stworzyć nową wersję takiego kamienia.

Nowy kamień z Rosetty zawiera strony wytrawione jako mikroskopijnej wielkości obrazy na niklowym krążku o średnicy 4 cali. W środku krążka umieszczona jest mapa wskazująca obszar, na którym mówi się danym językiem. Aby odczytać ten mikrodruk, wystarczy dysponować mikroskopem powiększającym tysiąc razy.

Dużo lepszym rozwiązaniem do tworzenia trwałych zapisów jest wykorzystanie MFM - Magnetic Force Microscope. Przy okazji tę technologię można wykorzystać, także do odczytywania nośników magnetycznych (może w przyszłości dokładniej to opiszę).

Natomiast jeżeli chodzi o bezpieczeństwo danych, to muszą one być oddzielone od sprzętu komputerowego i aplikacji. Powinny jednak być zależne od otwartych standardów.

W przechowaniu danych, bardzo ważne są metadane (czyli dane o danych, które sprawiają, że inne dane są użyteczne).

Metadane są ważnym sposobem uchwycenia kontekstu źródła oraz procesów definiujących i dotyczących jego wykorzystania.

Jednak występuje tutaj pewien problem. Występuje duża zawiłość wzajemnych powiązań między zasobami i różnymi aplikacjami, wykorzystywanymi do ich uruchamiania, która może zostać przeoczona przy tworzeniu elementów metadanych.

Tworzenie rekordów niezależnych od oprogramowania i sprzętu komputerowego wymaga, aby wszystkie materiały umieszczane w archiwach były połączone z informacją o ich strukturze, kontekście i historii ich wykorzystania. Metadane musza być na tyle wystarczające, aby wspomagać migrację rekordów przez różne generacje sprzętu komputerowego i oprogramowania, zapewnić rejestr kontroli przez cykl życia rekordu, wyposażyć rekordy w mechanizmy autoselekcji i autooceny oraz uchwycić wewnętrzną dokumentację.

Metadane powinny zawierać:

-informacje o źródle danych,

-szczegóły o tym, w jaki sposób, dlaczego i kiedy zostały utworzone,

-szczegóły na temat ich funkcji,

-wskazówki jak otworzyć i czytać dane,

-historię migracji rekordów i wszelkie zmiany jakie były wprowadzane,

-informacje jak meta dane związane są z innym oprogramowaniem i rekordami.

Niestety chyba nie można polegać jedynie na migracji. Zależy ona od regularnej konwersji zasobów ze starych form do nowych formatów, zanim te stare formaty staną się przestarzałe. Wygląd czy zachowanie cyfrowych zapisów często jest związana z oprogramowaniem czy sprzętem komputerowym.

Teraz przykład z mojego ulubionego działu retro. Posiadam plik stworzony na komputerze z systemem CP/M (1982) w programie Wordstar, który został przeniesiony na komputer typu PC z programem Wordstar w systemie DOS (1985), następnie przeniesiony do WordPerfect dla DOS (1989), a dalej do WordPerfect dla Windows (1993), a potem przez kolejne wersje formatów MS Office. Niestety nie udało się przenieść dynamicznych dokumentów stworzonych w Word 6 do Word 97 (makra). Przeniesione pliki nie wyświetlają pochodzenia danych (np. nagłówków), ponieważ istniały one tylko w makrach jako wyniki działania na zbiorach, a Microsoft zmienił język makr w kolejnej wersji Worda.

Dlatego uważam, że ze względu na zmienności i gwałtowne zmiany w informatyce, poleganie wyłącznie na migracji jest ryzykowne.

Im dłuższy czas od powstania cyfrowego materiału a czasem jego migracji tym wyższe koszty i możliwość przekłamania.

Bez względu na rodzaj długookresowego przechowywania materiały cyfrowe muszą być enkapsulowane (opakowane) z odpowiednimi odsyłaczami (np. opis typu danych, operacje, związki, kontekst, proweniencja itp.).

Wydaje mi się że warto także zastanowić się nad tym jakich danych dostarczymy przyszłym badaczom.

Czy odcięcie danych od środowiska, w którym zostały stworzone i wykorzystywane, deprecjonuje wiadomość?

Czasami bez oryginalnego oprogramowania do przetwarzania i udostępniania danych nie będzie możliwe określenie jakiego rodzaju rekordy użytkownicy mogli stworzyć i jak one były prezentowane. Tak jak współcześni historycy studiują archiwa w celu zrozumienia zasad działania i funkcjonowania administracji, tak historycy czy socjologowie będą patrzeć poza treść zapisów, aby zrozumieć w jaki sposób narzędzia i środowisko pracy warunkowało ludzi i ich pracę.

Jeżeli nie mamy dostępu do oryginalnego sprzętu czy oprogramowania to pozostaje nam emulacja. Umożliwi ona eksperymentowanie z historycznym sprzętem komputerowym oraz oprogramowaniem i ułatwi zrozumienie starych sposobów działania.

Niestety nie daje to takiego samego zrozumienia, które można osiągnąć przy dostępie do oryginalnego środowiska.

Computer Conservation Society (

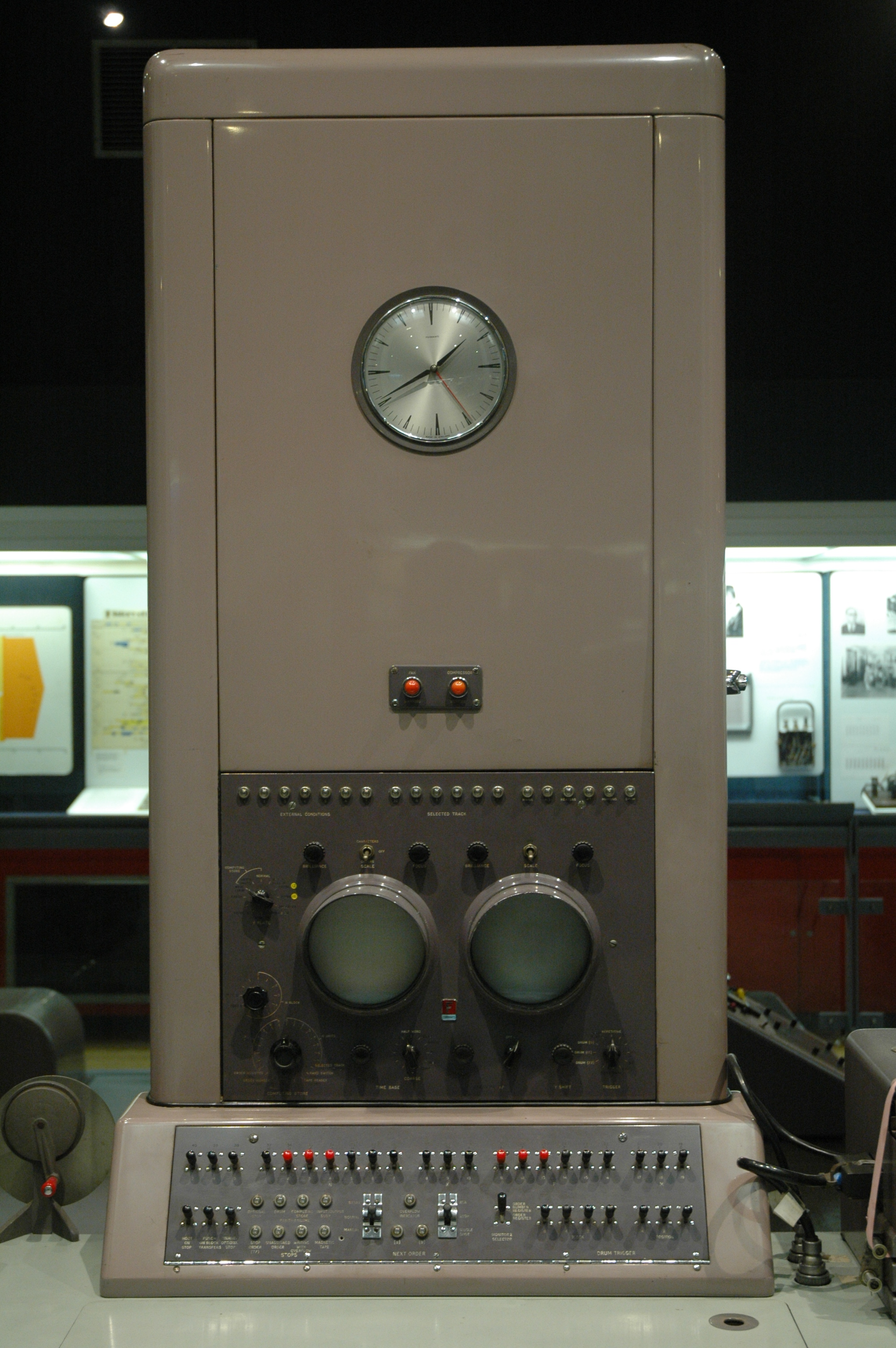

http://www.computerconservationsociety.org) opracowało symulację komputera z lat pięćdziesiątych Ferranti Pegasus, którą można uruchomić na komputerze PC.

Sama symulacja umożliwia użytkownikom przetwarzanie danych w sposób podobny do realizowanego przez Pegasusa, nie oddaje jednak samego wyobrażenia na temat sposobu pracy w latach 50.

Emulacja oferuje bezpieczny sposób zapewnienia dostępu do danych, oprogramowania i przedstawienia funkcji starszych systemów (postaram się przedstawić w przyszłości wyniki badań zespołu HATII - Instytutu naukowego na uniwersytecie w Glasgow).

W 2008 roku NASA ogłosiła że ludzie z całego świata mogą zgłaszać swoje imiona, które zostaną zapisane i wysłane wraz z sondą Lunar Reconnaissance Orbiter na orbitę Księżyca.

Ciekaw jestem jak długo przetrwają zapisane tam dane cyfrowe i czy w przyszłości będzie można je odczytać.